A Meta, a empresa controladora do Facebook, está testando seu primeiro chip desenvolvido internamente para o treinamento de sistemas de inteligência artificial, marcando um passo significativo na tentativa de diminuir a dependência de fornecedores externos como a Nvidia, de acordo com duas fontes da Reuters. A companhia, que é a maior rede social do mundo, iniciou uma pequena fase de testes do chip e planeja aumentar a produção se os resultados forem positivos, conforme informado pelas fontes.

Essa iniciativa de criar chips internamente é parte de um plano abrangente da Meta para reduzir os altos custos com infraestrutura, especialmente à medida que a empresa investe fortemente em ferramentas de inteligência artificial. A Meta, que também é responsável pelo Instagram e WhatsApp, projeta um gasto total de entre US$ 114 bilhões (aproximadamente R$ 665 bilhões) e US$ 119 bilhões (cerca de R$ 695 bilhões) em 2025, dos quais até US$ 65 bilhões (aproximadamente R$ 380 bilhões) são destinados a despesas de capital relacionadas, principalmente, com infraestrutura de IA.

Uma das fontes indicou que o novo chip de treinamento da Meta é um acelerador dedicado, projetado para realizar apenas tarefas específicas relacionadas à IA. Essa característica pode torná-lo mais eficiente em termos de consumo energético em comparação com as unidades de processamento gráfico (GPUs) que são normalmente utilizadas para essas cargas de trabalho. Também foi mencionado que a Meta está em parceria com a fabricante de chips TSMC, com sede em Taiwan, para a produção do chip.

O processo de teste começou após a Meta completar sua primeira etapa de “tape-out” do chip, que é um marco importante no desenvolvimento de silício, pois envolve o envio do projeto inicial para uma fábrica de chips, como apontou a outra fonte. Este passo, que costuma custar dezenas de milhões de dólares, leva de três a seis meses para ser realizado, sem garantia de que o teste será bem-sucedido. Caso haja falhas, a Meta terá que identificar o problema e repetir o processo de tape-out.

Tanto a Meta quanto a TSMC preferiram não comentar sobre o assunto. O chip em questão faz parte da série Meta Training and Inference Accelerator (MTIA) da empresa. Embora o programa tenha tido um início instável e até tenha descartado um chip em uma fase semelhante do desenvolvimento, no ano passado a Meta começou a utilizar um chip MTIA para executar inferências — o processo que ocorre quando um sistema de IA é acionado durante a interação dos usuários — para otimizar os sistemas de recomendação que definem quais conteúdos aparecem nos feeds de notícias do Facebook e do Instagram.

Os executivos da Meta afirmaram seu desejo de começar a implementar chips próprios até 2026 para o treinamento, que é o processo intensivo de computação que alimenta sistemas de IA com grandes volumes de dados, permitindo que eles aprendam a executar suas funções. Assim como no chip de inferência, o objetivo do novo chip de treinamento é começar com os sistemas de recomendação e, em seguida, expandir para produtos de IA generativa, como o Meta AI.

“Estamos explorando como desenvolver treinamento para sistemas de recomendação e, eventualmente, como integrar treinamento e inferência para IA generativa”, comentou Chris Cox, diretor de produtos da Meta, durante uma recente conferência de tecnologia. Cox descreveu o desenvolvimento do chip como uma jornada que vai do caminhar ao correr, mas destacou que o chip de inferência de primeira geração para recomendações foi considerado um “grande sucesso.”

Anteriormente, a Meta havia abandonado um chip de inferência personalizado após este falhar em um pequeno teste, semelhante ao que está sendo realizado agora com o chip de treinamento. Desde então, a empresa tem sido uma das principais clientes da Nvidia, acumulando uma vasta coleção de GPUs para treinar modelos, incluindo sistemas de recomendações e anúncios. Essas unidades também são usadas para realizar inferências para mais de 3 bilhões de usuários que utilizam seus aplicativos diariamente.

O valor dessas GPUs foi posto em discussão neste ano, conforme pesquisadores em IA manifestam crescente preocupação sobre o quanto de progresso realmente pode ser feito ao aumentar apenas o tamanho dos modelos de linguagem por meio da adição de mais dados e capacidade de computação. Essas incertezas foram intensificadas pelo lançamento, no final de janeiro, de novos modelos de baixo custo da startup chinesa DeepSeek, que melhoram a eficiência computacional ao se basear mais em inferência do que muitos modelos convencionais.

Referência: CNN

Posts relacionados:

Meta projeta investimentos em robôs humanoides com tecnologia de IA, conforme documento interno

Meta projeta investimentos em robôs humanoides com tecnologia de IA, conforme documento interno

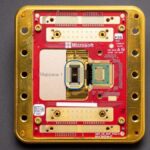

O chip quântico Majorana 1 da Microsoft ainda está a poucos qubits de completar sua meta

O chip quântico Majorana 1 da Microsoft ainda está a poucos qubits de completar sua meta

Seu negócio está preparado para a IA? 5 estratégias para não ficar para trás

Seu negócio está preparado para a IA? 5 estratégias para não ficar para trás

Meta AI inclui suporte para árabe no Oriente Médio e Norte da África.

Meta AI inclui suporte para árabe no Oriente Médio e Norte da África.